티스토리 뷰

목차

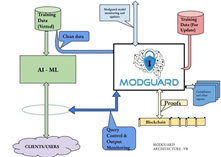

생성형 AI(LLM) 서비스 개발 시 필수적인 Guardrails 구현 방안

Guardrails의 개념과 필요성

Guardrails은 생성형 AI(Generative AI) 모델을 실제 서비스에 적용할 때 안전하고 책임감 있게 사용하기 위해 필요한 장치입니다. LLM(Large Language Model)과 같은 대규모 언어 모델은 방대한 데이터를 학습하기 때문에, 의도치 않게 유해한 콘텐츠를 생성하거나 편향성을 내재할 수 있습니다. 이를 방지하고 안정적인 서비스를 제공하기 위해서는 체계적인 Guardrails 구축이 필수적입니다.

Guardrails의 주요 역할과 구현 방안

1. 유해한 콘텐츠 필터링

생성형 AI 모델의 학습 데이터에는 유해하거나 부적절한 콘텐츠가 포함될 수 있습니다. 이를 방지하기 위해 출력 결과를 실시간으로 모니터링하고 필터링하는 모듈을 개발해야 합니다. 블랙리스트 기반 키워드 매칭, NSFW 이미지 감지 모델 등 다양한 기술을 활용할 수 있습니다.

2. 프롬프트 인젝션 방지

악의적인 사용자가 프롬프트를 조작하여 LLM을 의도하지 않은 방향으로 동작시키는 프롬프트 인젝션 공격을 막아야 합니다. 이를 위해 입력 프롬프트에 대한 강력한 검증, 특수문자 이스케이프, 화이트리스트 기반 프롬프트 구성 등의 방어 조치가 필요합니다.

데이터 프라이버시 보호와 편향성 완화

3. 데이터 프라이버시 보호

생성형 AI 모델의 학습 데이터에는 개인정보가 포함되어 있을 수 있습니다. 미세조정(Fine-tuning) 단계에서 차분 프라이버시(Differential Privacy) 기법 등을 적용해 개인정보 누출을 최소화해야 합니다. 추론 시에도 입력 데이터에 대한 엄격한 접근제어와 암호화가 필요합니다.

4. 편향성 완화

LLM은 학습 데이터의 편향을 그대로 반영할 우려가 있습니다. 이를 완화하기 위해서는 학습 데이터를 다양화하고, 공정성 지표를 모니터링하며, 편향성 완화 기법을 적용하는 등의 노력이 필요합니다. 추론 후처리 단계에서 편향성을 보정하는 방안도 고려할 수 있습니다.

설명 가능성 확보와 MLOps 파이프라인 구축

생성형 AI 모델의 예측 근거를 사용자에게 명확히 제시하는 것이 중요합니다. Feature attribution, Concept activation vector 등 설명 가능한 AI 기술을 활용하여 예측 과정을 시각화하고 설명할 수 있습니다.

Guardrails를 효과적으로 구현하기 위해서는 MLOps 파이프라인에 다양한 모니터링, 필터링, 보정 모듈을 추가하고, 지속적으로 성능을 평가 및 개선해 나가는 체계를 갖추어야 합니다. 기술적 방안 외에도 responsible AI에 대한 조직 문화 형성과 거버넌스 체계 수립 등 포괄적인 접근이 필요할 것입니다.

생성형 AI와 LLM 기술이 빠르게 발전하고 있는 만큼, Guardrails 구축을 통해 안전하고 신뢰할 수 있는 서비스 개발이 가능할 것으로 기대됩니다.

생성형 AI(LLM) Guardrails 구현에 관련한 핵심 질문

Q1. 유해 콘텐츠 필터링을 위해 가장 효과적인 방법은 무엇일까요?

생성형 AI 모델이 생성한 콘텐츠에서 유해하거나 부적절한 내용을 실시간으로 탐지하고 필터링하기 위해서는 다양한 접근 방식을 조합하는 것이 효과적입니다. 먼저, 유해 콘텐츠와 관련된 키워드를 정의하고 이를 기반으로 블랙리스트를 구축하여 매칭되는 콘텐츠를 차단할 수 있습니다. 또한, NSFW(Not Safe For Work) 이미지 감지 모델을 활용하여 시각적으로 유해한 콘텐츠를 필터링할 수 있습니다.

더 나아가, LLM의 출력 결과를 분석하여 유해성을 판단하는 AI 모델을 개발하고 적용하는 것도 고려할 수 있습니다. 이를 통해 키워드 기반 필터링으로는 걸러내기 어려운 문맥적으로 유해한 콘텐츠까지 탐지할 수 있습니다. 유해 콘텐츠 필터링은 지속적인 모니터링과 업데이트가 필요한 만큼, 전담 인력과 프로세스를 갖추는 것도 중요합니다.

Q2. 프롬프트 인젝션 공격을 막기 위한 가장 강력한 방어 전략은 무엇일까요?

프롬프트 인젝션은 악의적인 사용자가 입력 프롬프트를 조작하여 LLM을 의도하지 않은 방향으로 동작시키는 공격입니다. 이를 방어하기 위해서는 화이트리스트 기반의 프롬프트 제한과 입력 검증이 가장 효과적입니다. 먼저, 사용자의 입력을 받기 전에 미리 정의된 화이트리스트 내에서만 프롬프트를 구성하도록 제한할 수 있습니다. 또한, 입력받은 프롬프트에 대해 강력한 검증 로직을 적용하여 잠재적인 보안 위협을 사전에 차단해야 합니다.

입력 검증 시에는 특수문자, 스크립트 구문, 시스템 명령어 등 위험할 수 있는 요소들을 필터링하고, 허용된 문자와 패턴만 받아들이도록 해야 합니다. 프롬프트에 사용되는 자연어 처리 라이브러리의 보안 취약점을 주기적으로 점검하고 패치하는 것도 중요합니다. 마지막으로, 비정상적인 프롬프트 인젝션 시도를 실시간으로 모니터링하고 대응할 수 있는 보안 이벤트 관리 체계를 갖추는 것이 바람직합니다.

Q3. 생성형 AI 모델의 편향성을 효과적으로 측정하고 완화하기 위한 방안은 무엇일까요?

생성형 AI 모델이 학습 데이터의 편향성을 그대로 반영하여 차별적이거나 부적절한 결과를 출력할 위험이 있습니다. 이를 해결하기 위해서는 먼저 편향성을 측정할 수 있는 공정성 지표를 설정하고 주기적으로 모니터링해야 합니다. 예를 들어, 성별, 인종, 연령 등 민감한 속성에 대한 모델의 예측 결과를 다양한 공정성 척도(Demographic Parity, Equalized Odds 등)로 평가할 수 있습니다.

편향성이 발견되면, 이를 완화하기 위한 다양한 기법을 적용할 수 있습니다. 학습 데이터를 더욱 다양화하고 균형있게 구성하는 것이 가장 근본적인 해결책이 될 수 있습니다. 또한, Adversarial Debiasing, Reject Option Classification 등 편향성을 직접 완화하는 알고리즘을 모델에 적용할 수 있습니다. 후처리 단계에서는 Equality of Opportunity, Calibrated Equalized Odds 등의 기법으로 모델의 출력 결과를 보정하는 방안도 고려할 수 있습니다.

편향성 완화를 위해서는 기술적 접근뿐만 아니라, 개발 프로세스 전반에 걸친 인식 제고와 모니터링 체계 구축이 뒷받침되어야 합니다. 다양성과 포용성을 중시하는 조직 문화를 형성하고, 책임감 있는 AI 개발을 위한 윤리 가이드라인과 거버넌스 체계를 수립하는 것이 필요합니다.

생성형 AI와 LLM 기술의 발전과 함께 Guardrails의 중요성도 커지고 있습니다. 기술적 방안과 조직적 접근을 균형있게 추진하여 안전하고 신뢰할 수 있는 LLM 서비스를 개발해 나가야 할 것입니다.