티스토리 뷰

목차

안녕하세요, 테크씬입니다! AI와 언어 모델에 대한 최신 트렌드를 탐구하는 여러분을 환영합니다! 오늘은 인공지능 분야의 두 거대한 산, LLM(초거대 언어 모델)과 GPT(Generative Pre-trained Transformer)의 세계로 여러분을 안내하려고 합니다. 이 블로그 포스팅을 통해, 이들 모델이 어떻게 우리의 언어를 이해하고, 어떻게 새로운 차원의 커뮤니케이션 능력을 펼쳐 보이는지 함께 탐구해 보겠습니다.

LLM과 GPT: 언어 이해의 새로운 지평을 열다

이 글에서는 LLM과 GPT, 그리고 그들의 최신 버전인 LLaMA-2 모델에 대해 깊이 있게 탐구할 것입니다. 우리는 이들 모델이 어떻게 프리트레이닝과 파인튜닝을 통해 언어를 배우고, 어떻게 이 지식을 다양한 분야에 적용하는지 살펴볼 예정입니다. 또한, 이들 모델의 차이점과 유사 모델들에 대해서도 자세히 이야기해 보려고 합니다.

AI 언어 모델: 오늘과 내일을 잇는 다리

이제 우리의 여정을 마무리하며, LLM과 GPT, 그리고 LLaMA-2 모델이 어떻게 인공지능 언어 처리의 새로운 지평을 열고 있는지를 정리해 보겠습니다. 이들 모델은 단순히 텍스트를 생성하고 해석하는 데 그치지 않고, 인간의 언어를 더욱 깊이 있게 이해하고, 더욱 정교하게 반응하는 능력을 지니고 있습니다. 이는 인공지능 기술이 인간의 언어와 소통의 본질을 어떻게 변화시킬 수 있는지를 보여줍니다.

초거대 언어 모델의 진화: LLM의 발전과 중요성

초거대 언어 모델(LLM)은 인공지능 분야에서 혁신적인 발전을 이루어낸 기술입니다. 이들은 대규모 데이터셋을 활용하여 복잡한 언어 이해와 생성 능력을 개발합니다. 이러한 모델은 텍스트 번역, 질의응답, 자연 언어 이해 등 다양한 언어 작업에 활용됩니다. LLM은 기존의 작은 규모 모델들보다 훨씬 광범위한 데이터를 처리하고, 더 정교한 언어 패턴을 학습함으로써 인간과 유사한 언어 처리 능력을 제공합니다.

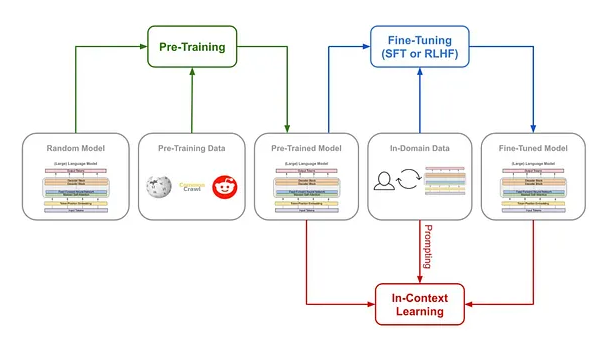

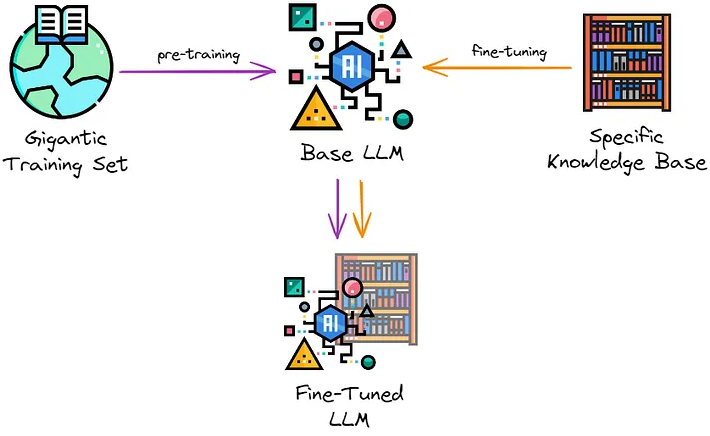

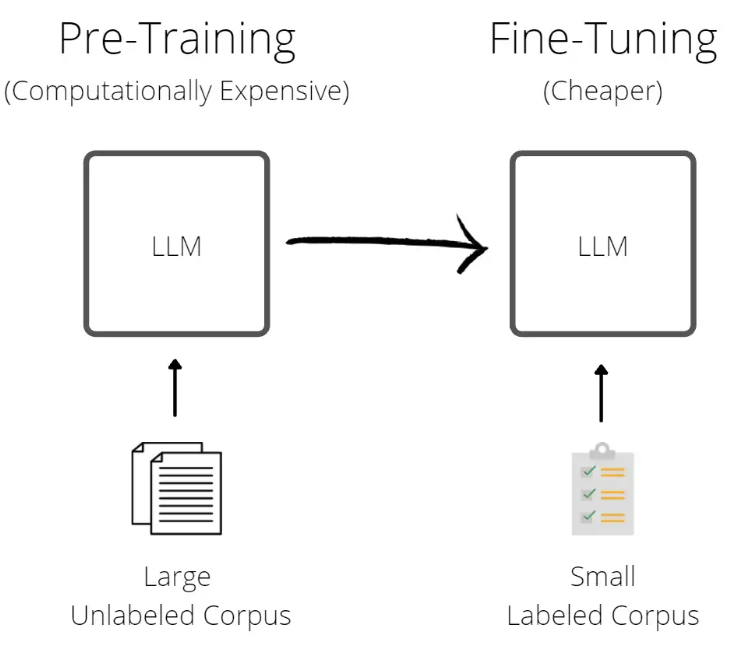

프리트레이닝(Pre-Training): 초거대 언어 모델의 기반 마련

- 목적: 프리트레이닝은 LLM에게 광범위한 언어 이해력을 부여합니다. 이는 모델이 다양한 언어 현상을 이해하고, 새로운 상황에 대처할 수 있는 능력을 개발하는 데 도움을 줍니다.

- 방법: 인터넷 텍스트, 책, 기사 등 다양한 출처에서 수집된 대규모 데이터셋을 사용합니다. 이 데이터는 다양한 언어, 문체, 주제를 포함하여 모델이 보다 넓은 지식 범위를 학습할 수 있도록 합니다.

- 비유: 프리트레이닝은 학생이 학교에서 다양한 과목을 배우는 것과 유사합니다. 여기서 학생은 수학, 과학, 언어 등 다양한 분야에 대한 기본 지식을 습득합니다.

파인튜닝(Fine-Tuning): 특화된 작업 수행을 위한 LLM의 조정

- 목적: 파인튜닝은 LLM이 특정 작업이나 분야에 더 잘 적응하도록 만듭니다. 이는 모델이 특정 도메인의 언어 사용 패턴, 전문 용어, 개념에 익숙해지도록 돕습니다.

- 방법: 의료 텍스트, 법률 문서, 고객 서비스 대화 등 특정 분야에 초점을 맞춘 데이터셋을 사용합니다. 이를 통해 모델은 해당 분야의 특정한 언어 구조와 용어에 더 익숙해질 수 있습니다.

- 비유: 파인튜닝은 대학에서 학생이 특정 전공을 선택해 깊이 있는 학습을 하는 것과 비슷합니다. 여기서 학생은 전공 분야의 전문 지식을 쌓고, 해당 분야의 세부적인 내용을 학습합니다.

구체적인 예시: '사과(Apple)'의 다양한 의미 학습

'사과'라는 단어는 LLM의 학습 과정에서 다양한 의미를 갖습니다. 프리트레이닝에서는 '사과'가 과일로서의 의미를 학습합니다. 이후 파인튜닝을 통해, 예를 들어 의학 분야에서는 '애플 워치'와 관련된 건강 데이터나, 고객 서비스에서는 사과의 의사소통적 의미 등을 이해하게 될 수 있겠죠.^^. 이러한 과정은 모델이 단어의 다양한 사용 상황을 이해하고 적절하게 반응할 수 있도록 합니다. 맥락이 중요하다는 것입니다!

파운데이션 모델: LLM의 다목적 기반 구축

- 정의: 파운데이션 모델은 다양한 언어 작업에 적용 가능한, 대규모 프리트레이닝된 모델을 말합니다. 이 모델들은 일반적인 언어 이해와 생성 능력을 갖추고 있으며, 다양한 작업과 상황에 유연하게 적응할 수 있습니다.

- 비유: 파운데이션 모델은 다목적 건물과 같습니다. 이 AI 모델이 만약 건물이라면, 이는 기본적인 구조가 견고하며, 사무실, 아파트, 상점 등 다양한 용도로 재구성할 수 있습니다. 즉, 범용적이고 다용도로 사용할 수 있다는 것이죠.^^.

- 프리트레이닝의 역할: 파운데이션 모델을 만드는 핵심 과정입니다. 이 과정을 통해 모델은 다양한 언어 데이터를 학습하고, 이를 기반으로 다목적 언어 처리 능력을 개발합니다.

파운데이션 모델과 프리트레이닝: 차이점과 공통점

- 차이점: 파운데이션 모델은 대규모의 프리트레이닝된 모델 자체를 의미합니다. 반면, 프리트레이닝은 이러한 모델을 생성하기 위한 과정을 지칭합니다.

- 공통점: 둘 다 모델의 다목적성과 광범위한 적용 가능성에 중점을 둡니다. 이를 통해 모델은 다양한 언어 작업을 수행할 수 있는 능력을 갖춥니다.

LLaMA-2 모델: LLaMA의 진화와 성능 개선

LLaMA-2 모델은 기존 LLaMA 모델의 발전된 버전으로, 여러 개선 사항을 통해 성능이 크게 향상되었습니다. 이 모델은 인공지능과 언어 처리 분야에서 중요한 진보를 대표하며, 특히 복잡한 언어 작업을 더 효과적으로 수행할 수 있게 되었습니다.

LLaMA-2 모델의 주요 개선 사항

- 데이터 정제 강화: LLaMA-2는 데이터 정제 과정을 강화하여, 더 정확하고 신뢰할 수 있는 데이터를 학습합니다. 이를 통해 모델은 더 정확한 언어 이해와 생성 능력을 개발합니다.

- 데이터 믹스의 업데이트: 다양한 출처와 주제의 데이터를 포함시키는 것으로, 모델의 학습 범위와 깊이를 확장합니다.

- 총 토큰 수의 증가: 모델이 학습하는 데이터의 양을 증가시켜, 더 많은 언어 패턴과 상황을 이해할 수 있게 됩니다.

- 컨텍스트 길이의 증가: 더 긴 텍스트 조각을 이해하고 처리할 수 있게 하여, 복잡한 언어 작업에 대한 모델의 능력을 강화합니다.

- 그룹화된 쿼리 주의(GQA)의 사용: 이 기술은 모델이 더 효율적으로 대규모 데이터를 처리하고, 더 정확한 결과를 생성할 수 있도록 합니다.

추가적인 프리트레이닝의 장점

- 특정 도메인에 대한 이해력 증가: 추가적인 프리트레이닝을 통해, LLaMA-2는 특정 분야의 언어 사용 패턴과 전문 용어를 더 잘 이해하게 됩니다. 예를 들어, 의료 분야에서 사용되는 전문적인 용어나 법률 분야의 복잡한 문서를 더 효과적으로 처리할 수 있습니다.

- 최신 데이터의 반영: 시간이 지남에 따라 새로운 데이터와 정보가 축적됩니다. LLaMA-2는 이러한 최신 데이터를 반영하여, 시대에 맞는 언어 처리 능력을 유지합니다.

- 성능의 개선: 추가적인 프리트레이닝을 통해 모델은 더 복잡하고 다양한 언어 패턴을 학습합니다. 이는 전반적인 성능의 개선으로 이어지며, 모델이 더 정교하고 정확한 언어 처리를 할 수 있게 됩니다.

GPT와 LLaMA 모델의 차이점 및 유사 모델들

인공지능 분야에서 GPT(Generative Pre-trained Transformer)와 LLaMA(Large Language Model - Meta AI)는 두 가지 주요한 언어 모델입니다. 이 두 모델은 유사점을 공유하면서도 각기 다른 특징과 성능을 보여줍니다. 이 챕터에서는 GPT와 LLaMA 모델의 주요 차이점과 유사 모델에 대해 탐구하겠습니다.

GPT와 LLaMA 모델의 주요 차이점

- 구조와 학습 방법: GPT는 변형된 트랜스포머 구조를 사용하며, 더 큰 데이터셋과 복잡한 학습 과정을 통해 언어 모델을 구축합니다. 반면, LLaMA 모델은 메타 AI에서 개발한 모델로, 특정한 학습 방법과 데이터 처리 기법을 사용하여 언어 이해력을 향상합니다.

- 적용 범위와 성능: GPT는 다양한 언어 작업에서 뛰어난 성능을 보이며, 특히 창의적인 텍스트 생성과 자연스러운 대화에서 강점을 보입니다. LLaMA 모델은 특정 분야에 특화된 학습을 통해 특정 분야에서의 언어 이해력과 처리 능력에서 높은 성능을 나타냅니다.

- 학습 데이터셋의 차이: GPT는 다양한 출처의 데이터를 통해 학습되며, 이는 모델이 광범위한 언어 패턴과 문화적 다양성을 포괄합니다. LLaMA 모델은 특정한 데이터셋을 통해 특화된 학습을 진행하며, 이는 특정 분야에 대한 깊이 있는 이해력을 제공합니다.

GPT와 LLaMA 모델의 유사점

- 대규모 언어 모델: 두 모델 모두 대규모 언어 모델로, 광범위한 데이터를 학습하여 언어의 복잡성과 다양성을 이해하고 처리할 수 있는 능력을 갖추고 있습니다.

- 다용도 언어 처리 능력: GPT와 LLaMA 모두 다양한 언어 작업에 적용 가능하며, 텍스트 생성, 요약, 번역 등 다양한 작업을 수행할 수 있습니다.

- 인공지능 언어 처리의 혁신: 이 두 모델은 인공지능 언어 처리 분야에서 혁신을 대표하며, 자연어 이해와 생성 분야에서 새로운 가능성을 열어줍니다.

유사 언어 모델들

LLaMA와 GPT 외에도 인공지능 언어 모델 분야에서는 다양한 다른 모델들이 있습니다. 이들 모델은 각각 독특한 특성과 강점을 가지고 있으며, 특정 분야나 작업에 적합한 성능을 제공합니다.

- BERT (Bidirectional Encoder Representations from Transformers): BERT는 양방향 트랜스포머를 기반으로 하며, 특히 문맥 이해력에서 뛰어난 성능을 보입니다. BERT는 문장 내 단어의 문맥을 파악하여 더 정확한 언어 이해를 가능하게 합니다.

- RoBERTa (Robustly Optimized BERT Pretraining Approach): RoBERTa는 BERT의 변형 모델로, 더 큰 데이터셋과 더 긴 학습을 통해 BERT보다 개선된 성능을 제공합니다. 이 모델은 특히 자연어 이해 작업에서 뛰어난 결과를 보입니다.

- T5 (Text-To-Text Transfer Transformer): T5는 모든 언어 작업을 텍스트 변환 작업으로 간주하며, 이를 통해 다양한 작업을 통합적으로 학습합니다. T5는 번역, 요약, 질의응답 등 다양한 작업에 효과적입니다.

이러한 다양한 모델들은 각각 특정한 작업과 목적에 최적화되어 있으며, 인공지능 언어 처리 분야의 발전에 기여하고 있습니다. GPT와 LLaMA 모델은 이러한 모델들 중에서도 특히 주목할 만한 성과를 보여주고 있으며, 앞으로의 인공지능 언어 처리 분야의 발전에 중요한 역할을 할 것으로 예상됩니다.

미래를 향한 발걸음: LLM과 GPT의 지속적인 발전

LLM과 GPT, 그리고 그들의 발전된 형태인 LLaMA-2 모델은 앞으로도 계속 발전할 것입니다. 이들 모델은 인공지능 언어 처리 분야에서 끊임없는 혁신을 이끌고, 우리가 언어를 이해하고 사용하는 방식에 큰 영향을 미칠 것입니다. 이러한 변화는 우리 모두에게 새로운 커뮤니케이션의 기회를 제공하며, 미래의 언어 사용 방식을 재정의할 것입니다. 이 글을 통해, 여러분도 LLM과 GPT의 매력에 빠져보셨기를 바랍니다. 그럼 다음번에 또 만나요! 오늘도 테크씬이었습니다!

'AI' 카테고리의 다른 글

| 챗GPT가 만난 RAG : Few-Shot LLM으로 탄생한 차세대 GenAI (2) | 2023.12.17 |

|---|---|

| GPT 및 Seq2Seq 혁명 : 딥러닝 인코더와 디코더가 만들어내는 똑똑한 챗봇 세계 (feat. 챗GPT, NLP) (3) | 2023.12.03 |

| 차원 축소 마스터 : PCA, LDA, TSNE, 오토인코더, 임베딩 활용한 클러스터링과 군집화의 비밀 (0) | 2023.11.24 |

| 챗GPT LLM, 빙산의 일각과 숨겨진 사실들 : Finetuning, RAG, 프롬프트 엔지니어링, ChatGPT (0) | 2023.11.11 |

| DT IT 개념 비교 : IT DT DX 차이점 (feat. 디지털리터러시) (1) | 2023.10.31 |